«Un robot non può recare danno agli esseri umani, né può permettere che, a causa del suo mancato intervento, gli esseri umani ricevano danno». Il padre della fantascienza Isaac Asimov già nel 1950, immaginando potenzialità e rischi di un futuro robotizzato, proponeva nei suoi romanzi la “prima legge della robotica”. Da allora la scienza e la tecnologia hanno fatto progressi enormi. La legge sui robot è ancora solo fantascienza.

Da anni la ricerca militare studia armi letali autonome – in inglese LAWS (Lethal autonomous weapons systems) – per selezionare e distruggere il bersaglio senza controllo umano. Terminator, il film del 1984, raccontava di un cyborg assassino. E Stop killer robots è il nome della campagna internazionale – 250 organizzazioni della società civile mondiale – che chiede un Trattato internazionale.

Un tema attualissimo (in Ucraina e a Gaza le sperimentazioni sono sul campo) di cui si discute oggi pomeriggio a Roma, alla facoltà di Scienze politiche della Sapienza, al convegno “Intelligenza delle macchine e follia della guerra: le armi letali autonome”, organizzato da Archivio Disarmo e da Rete italiana pace e disarmo, assieme alla Campagna internazionale, Amnesty International, Croce Rossa italiana e Etica Sgr. Tra gli interventi, anche Peter Asaro, numero due di Stop killer robots.

L’obiettivo immediato è sostenere l’approvazione, alla sessione di ottobre dell’Assemblea generale delle Nazioni Unite della risoluzione sulle arme autonome. Promossa dall’Austria come capofila di altri stati, segue quella analoga del 2023 votata da 164 stati, 5 contrari (Bielorussia, Russia, India, Mali e Niger) e 8 astenuti (Cina, Corea del Nord, Iran, Israele, Arabia Saudita, Siria, Turchia e Emirato arabi). Consolidare un’ampio fronte politico come tappa verso un Trattato giuridicamente vincolante.

L’attenzione dell’Italia, oltre che dal sì alla risoluzione nel 2023, è testimoniata anche dal fatto che i promotori del convegno sono stati ricevuti l’8 ottobre al Quirinale dal presidente Sergio Mattarella.

Richiami accorati a una regolamentazione delle LAWS sono arrivati più volte anche da Papa Francesco. A giugno, al G7 in Puglia, ha definito «urgente ripensare lo sviluppo e l’utilizzo di dispositivi come le cosiddette “armi letali autonome” per bandirne l’uso».

Concorda il professor Fabrizio Battistelli, presidente di Archivio Disarmo: «L’intelligenza aritificiale (AI) è un fattore potente e rivoluzionario che, come sempre, può portare grandi progressi o rischi inauditi. A cominciare dalle responsabilità in campo militare, strategiche e tattiche. Strategicamente le LAWS possono rendere più facile lo scatenarsi dei conflitti, saltando l’ostacolo principale, almeno nelle democrazie rappresentative, cioè le perdite umane dei propri eserciti. La resistenza delle opinioni pubbliche per i governi è ancora un freno. È l’illusione delle “perdite zero”».

Dal punto di vista tattico poi, ragiona Battistelli, «un’arma con AI è in grado di riconoscere un nemico identificato, non di distinguere un miliziano confuso tra i civili. I rischi sono enormi. E senza più responsabilità umana. È urgente creare norme internazionali come già fatto per le armi biologiche, chimiche, per le mine antipersona».

Concorda Riccardo Noury, portavoce di Amnesty International Italia: «C’è una pericolosa sottovalutazione dell’impatto che l’AI può avere sull’automazione dei conflitti. Grande è il ritardo normativo. L’UE ha prodotto nel 2021 un pronunciamento non particolarmente vigoroso. Ora con l’Assemblea NU c’è l’occasione di dare seguito alla prima risoluzione, più che altro espressione di una preoccupazione internazionale. È necessario un passo avanti, per arrivare a un trattato vincolante. Come l’Att sul commercio internazionale di armi: anche se non abbastanza rispettato, afferma un principio fornendo un appiglio legale».

Togliere all’uomo la decisione finale sull’uso delle armi apre a esiti imprevedibili, sottolinea Noury. «Chi avrà la responsabilità? Il ministero della Difesa? L’azienda produttrice? E se queste tecnologie finiranno nelle mani di gruppi non statali? Miliziani, jihadisti, mercenari? Sulla proliferazione delle armi autonome va posto un tabù».

________________________________________________________________

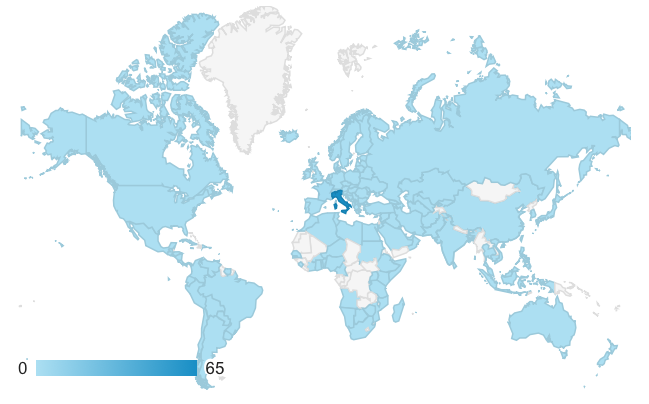

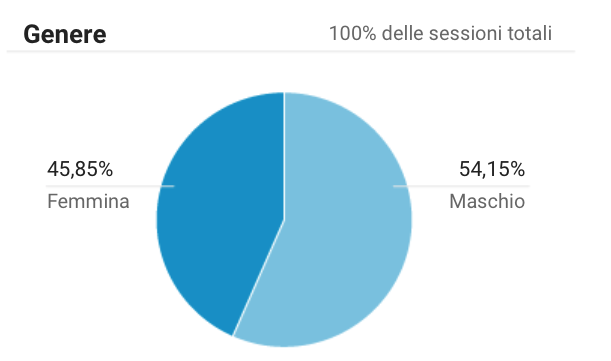

COSTA PARADISO NEWS SUPERA 700mila VISUALIZZAZIONI DI PAGINA IN 160 STATI E 1200 LOCALITÀ ITALIANE

(Google analytics 02 gennaio 2024)

_______________________________________________________________

In osservanza al nuovo Regolamento Europeo sulla Protezione dei Dati (GDPR), gli indirizzi mail sono conservati in modo sicuro e utilizzati esclusivamente per informare sulle attività da noi pubblicate.

Potrà cancellarsi dalle newsletter inviando un email al seguente indirizzo: redazione@costaparadisonews.it

Informativa sulla Privacy – Questa operazione è obbligatoria.

________________________________________________________________

Costa Paradiso News non è un prodotto editoriale, viene aggiornato in base al materiale ricevuto dai lettori o da pubblicazioni viste sul web.

I commenti agli articoli e gli annunci delle rubriche sono gratuiti e devono rispettare tutte le leggi e i regolamenti vigenti in Italia.

Gli annunci vengono pubblicati sempre sotto la sola responsabilità dell’utente, che all’atto della richiesta dell’annuncio dichiara altresì di conoscere e accettare le Condizioni Generali di Servizio.

La redazione di Costaparadisonews non potrà essere ritenuta responsabile ad alcun titolo per quanto descritto dagli utenti e per la loro condotta.

Le relazioni intrattenute tra gli utenti del Servizio, incluso l’acquisto, lo scambio di informazioni, anche per il tramite del form di risposta all’annuncio, la consegna o il pagamento di beni o servizi, avvengono esclusivamente tra utenti senza che Costaparadisonews sia parte della relazione.

______________________________________________________________

Informativa sulla Privacy

______________________________________________________________

Questo sito utilizza i cookie e tecnologie simili. Puoi disabilitare i cookie sul tuo browser, oppure accettarli e continuare a navigare.

PER SAPERNE DI PIÙ

______________________________________________________________

.